Syncast 技術検証レポート - Vol.01

Syncast Tech Report Vol.1オフライン画像認識 × エッジAI × Ditto

「セキュリティの壁」や「通信環境の欠如」で、DXを諦めていませんか?

K&Kソリューションは、ネットワークに接続できない設備を、カメラとエッジAIを用いてデータ化する「非接触・後付け」の技術検証を行っています。インターネットに繋がずに、デバイス間のローカル通信のみで、モニターの数値や現場の状況を収集・活用する手法とその可能性を公開します。

検証サマリー

- ● 検証結果: ネットを介さずに、計器の「数値読み取り」と「状況の言語化」の双方に成功

- ● 技術的成果: エッジAIによる情報のデータ化とDittoによるオフライン連携の有効性を確認

- ● 適用可能性: 通信不可エリアでのデータ収集に加え、自律監視ソリューションへの応用を確認

検証の背景:本検証で解決を目指した「3つの課題」

多くの現場では、「見ればわかる」情報がデータ化されずに捨てられています。

私たちは、既存のDXソリューションが抱える以下の「3つの壁」こそが阻害要因であると仮説を立て、

これを「既存設備を一切変えずに」突破するための技術検証を行いました。

制御盤や重要インフラには「外部ネットワーク接続禁止(エアギャップ)」の運用ルールがあり、クラウド連携が許可されない。

古いシステムの改修には、ベンダーへの莫大な費用や、停止・再検証のリスクが伴うため、手が出せない。

山間部、地下、機内など、そもそもWi-Fiやキャリア電波が届かないため、従来のIoT機器が使えない。

検証内容1:オフラインOCRとデータ連携

「アナログ表示を、デジタルデータへ」

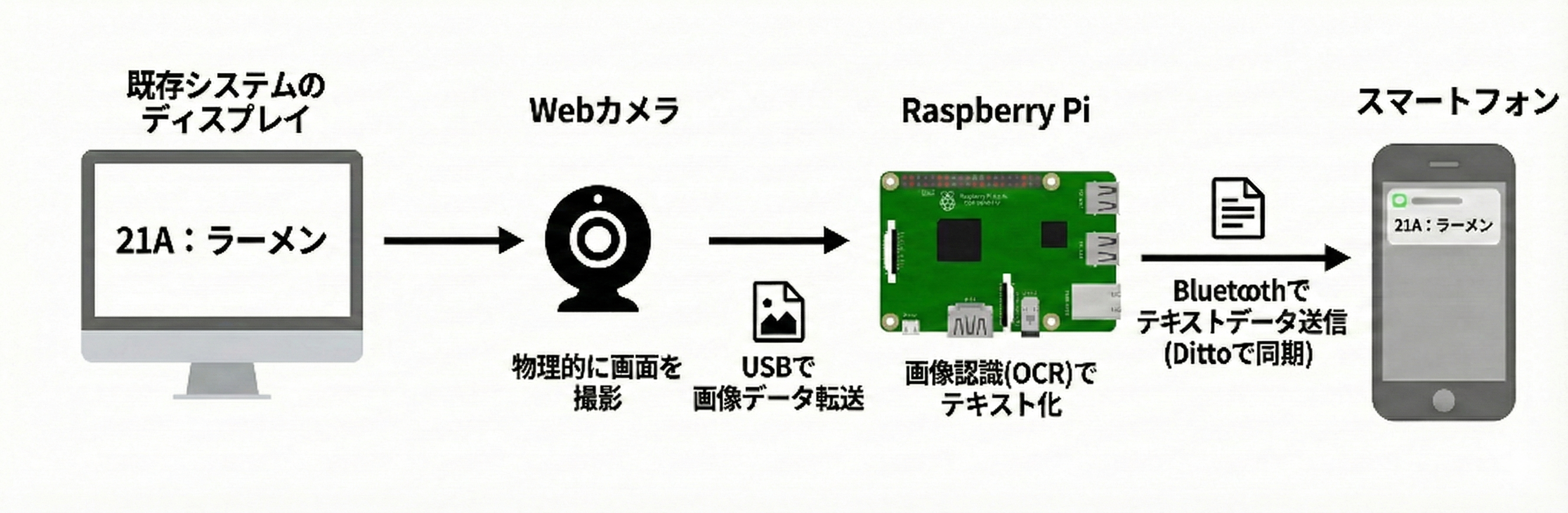

Webカメラが画面を撮影し、エッジAIが数値を読み取り、Ditto技術で通知を行う仕組みを構築しました。

システム構成イメージ

ハードウェアには Raspberry Pi 5 と市販のUSBウェブカメラを使用。

ソフトウェアは Python (Tesseract) と Node.js (Ditto) を連携させています。

実装ロジックの処理フロー

この構成により、既存のケーブルやプログラムには触れない(Zero Interference)安全な導入と、

通信費のかからない運用を実現しました。

検証内容2:エッジでの視覚言語モデル(VLM)

OCRによる「数値」の読み取りに加え、カメラ映像そのものをAIが「理解」し、状況をテキストで説明する

視覚言語モデル(VLM)の動作検証も行いました。

クラウドのLLMを使わず、エッジデバイスのみで高度な認識処理を行う試みです。

検証内容: 画像の意味理解

Raspberry Pi 4上でローカルVLMを稼働させ、以下のプロンプトで推論を実行。

検証結果と監視ソリューションへの展望

- 高度な認識能力: 文字情報だけでなく、人物、車種、犬などの物体認識と、それらの関係性(隣に座っている等)までを正確に言語化することに成功しました。

- 処理時間の壁: 現在の構成では推論完了までに約4分(画像のエンコーディング含む)を要しています。これはリアルタイム監視には長い時間です。

- 今後の対策: モデルの量子化(軽量化)や、動体検知トリガー(動きがあった時だけVLMを動かす)との組み合わせにより、実運用レベルまでの高速化・最適化を目指します。

- 活用可能性: この技術を応用することで、工場内での危険エリアへの立ち入り検知や、自然環境における変化(河川の増水、動物の出現)の定点観測など、通信環境のない場所での自律的な監視ソリューションの実現が期待できます。

※ 本検証で生成されたテキストデータも、検証1と同様の仕組み(Ditto)を用いてオフライン環境下でのデータ連携が可能です。

今後の活用・応用イメージ

OCRとVLM、2つのアプローチであらゆる「オフライン現場」の課題解決を目指します。

エッジAIロボット

防犯・巡回ロボットに搭載。通信できない死角エリアでも、VLMで「不審物」や「異常」を自律的に判断・記録する。

BCP / 災害対策

システムダウン時、緊急で届くFAX注文書をカメラで読み取り、オフラインで注文データ化して現場へ連携。

この技術を、一緒に育てませんか?

Syncastシリーズ及びDittoに関するお問い合わせ、端末間通信を実現するアプリケーションの制作のご相談はもちろん、

本プロジェクトを推進するビジネスメンバー・開発メンバーも募集しています。

下記フォームもしくは下記メールアドレスまでご連絡ください。